はじめに:そのAIエージェント、本当に「現場」に出せますか?

近年、「AIエージェント」という言葉を耳にする機会は急速に増えています。一方で、期待した成果が得られない、ROIが見えにくいといった理由から、AIエージェントを全社レベルで本格活用できている企業は、まだ限られているのが実情です。

多くの企業では、AIエージェントを「便利なツール」として評価しながらも、LLMアプリケーションと比較した際に投資対効果が不透明であり、基幹業務プロセスや運用設計に組み込む段階まで踏み込めていません。

しかし、海外では状況が変わり始めています。

単なるタスク補助にとどまるコパイロット型のAIから、自ら考え、判断し、行動を提案、実行する「同僚」のような存在として、エージェント型AI(Agentic AI)へと進化しつつあります。

こうした動きを前に、日本のOTエンジニアの多くは、次のような懸念を抱いているのではないでしょうか。

- AIエージェントが増えるほど、制御不能にならないか

- 誰が、どのAIエージェントが、何を判断したのかを追跡できるのか

- 現場の安全性や責務分離、監査要件に耐えられるのか

- AIエージェントの判断精度を、継続的にどう高めるのか

この直感は、極めて本質的なものです。

エージェント型AIの普及がもたらす「新しい複雑性」

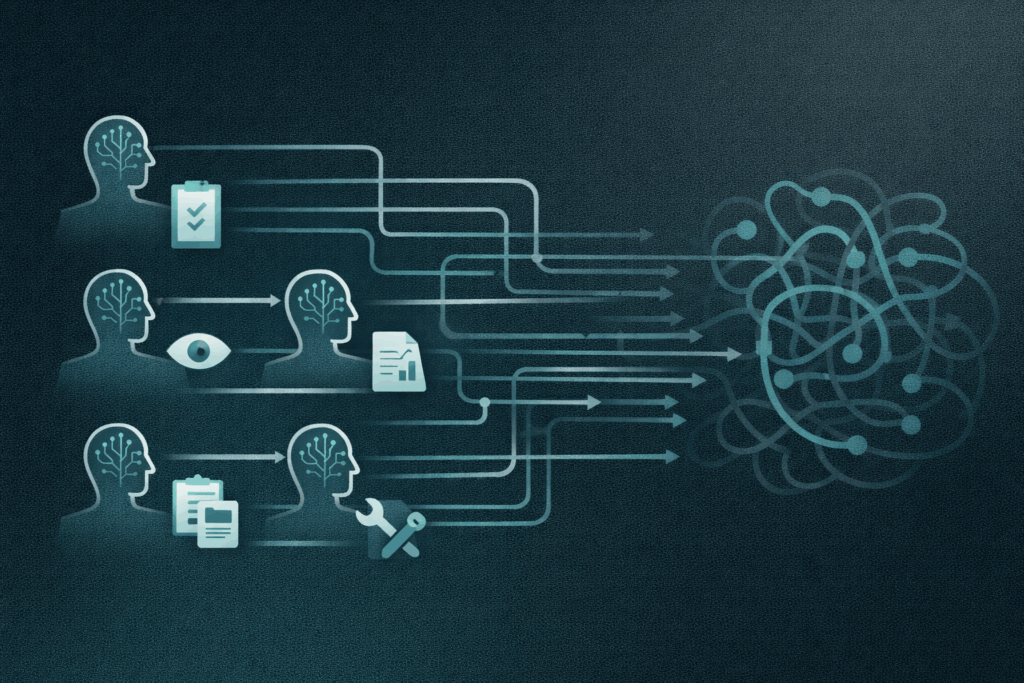

今後のAI活用は、1つの高性能なLLMにすべてを任せる世界ではありません。

実際には、役割の異なる複数のAIエージェントが並列、あるいは階層的に配置される構成へと進んでいきます。

例えば、

- 計画を立てるAIエージェント

- 状況を監視するAIエージェント

- データを収集、整理、分析するAIエージェント

- 判断や実行を支援するAIエージェント

といった分業が前提になります。

これはOTの世界で言えば、

- PLC

- DCS

- SCADA

- 保全システム

- MES

といったシステム群が、明確なI/O定義や責務分離なしに相互接続され始める状態に非常に近いと言えます。

このまま設計思想を持たずに進めば、LLMそのものは賢くなる一方で、AIエージェントの運用は確実に複雑化し、制御不能な状態へと向かいます。

問題の本質はLLMではなく「設計」にある

ここで強調すべきなのは、問題の本質がLLMの性能やモデルの優劣ではないという点です。

AIが意思決定を行うために必要なコンテキストやナレッジが、適切に共有、制御される設計になっていないことこそが課題です。

OTの世界では、次のような考え方が当たり前に存在します。

- I/Oは仕様として明確に定義する

- 操作可能な信号と、触れてはいけない信号を分離する

- 直接制御と間接制御を切り分ける

- 誰が、いつ、何をしたかを必ず追跡できるようにする

- 禁止操作を事前に定義する

- データの取得元や更新ルールを明確にする

一方、AI活用の議論では、こうした設計思想が抜け落ちたまま「AIをより賢くする話」だけが先行しがちです。

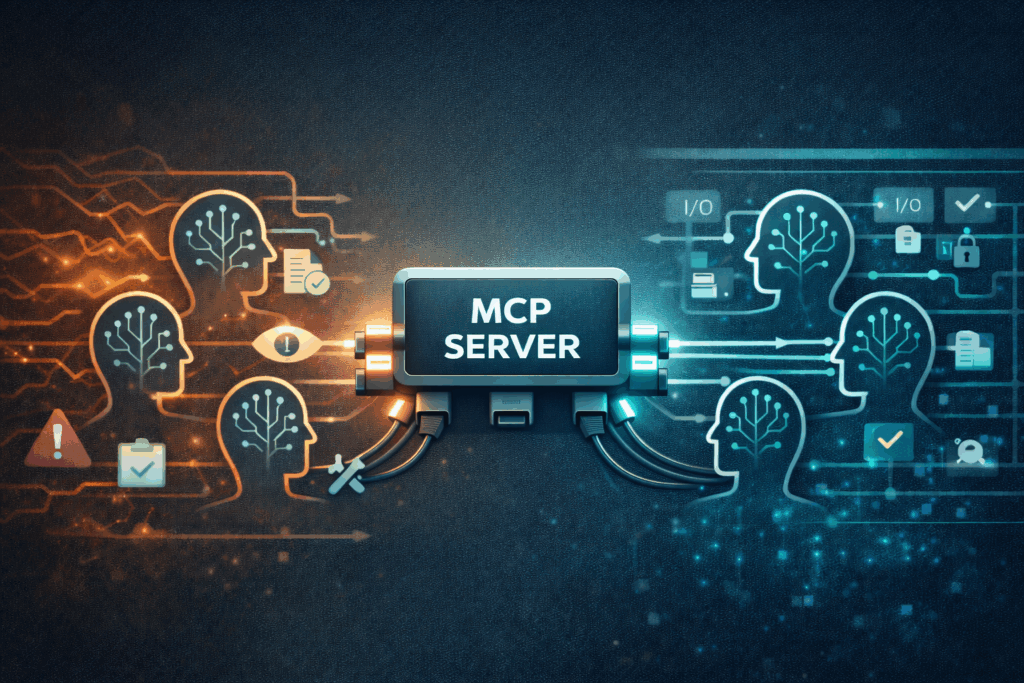

MCP Serverとは何か:AIのための「USB-Cハブ」

この課題に対する現実的な答えの1つが、MCP Server(Model Context Protocol Server)です。

Anthropic主導で始まったこの仕様は、現在Linux Foundation配下に入り、特定ベンダーに依存しない中立的な標準としての位置づけが明確になりつつあります。

MCP Serverを一言で表すなら、「AIのためのUSB-Cハブ」です。

USB-Cハブが果たす役割を思い浮かべると、理解しやすいでしょう。

- 接続口を統一する

- 流してよい信号や電力を制御する

- 接続機器の役割や責務を明確にする

- 不正接続や過負荷を防止する

MCP Serverも、AIエージェントと業務システムの間で、同様の役割を担います。

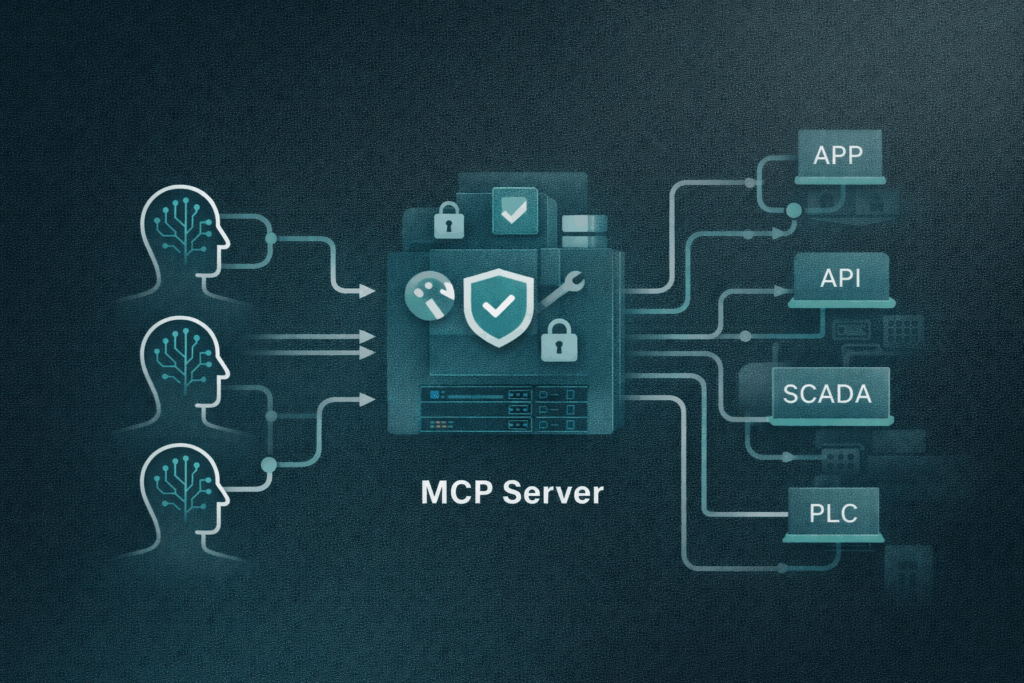

全社レベルで求められるEnterprise MCP Serverの役割

一般的なMCP Serverは、接続先が限定されていたり、ガバナンスやセキュリティが十分に考慮されていないケースも少なくありません。その結果、単なる「接続基盤」にとどまりがちです。

一方、全社レベルでAIを活用するためには、「制御基盤」として機能するEnterprise MCP Serverが不可欠になります。

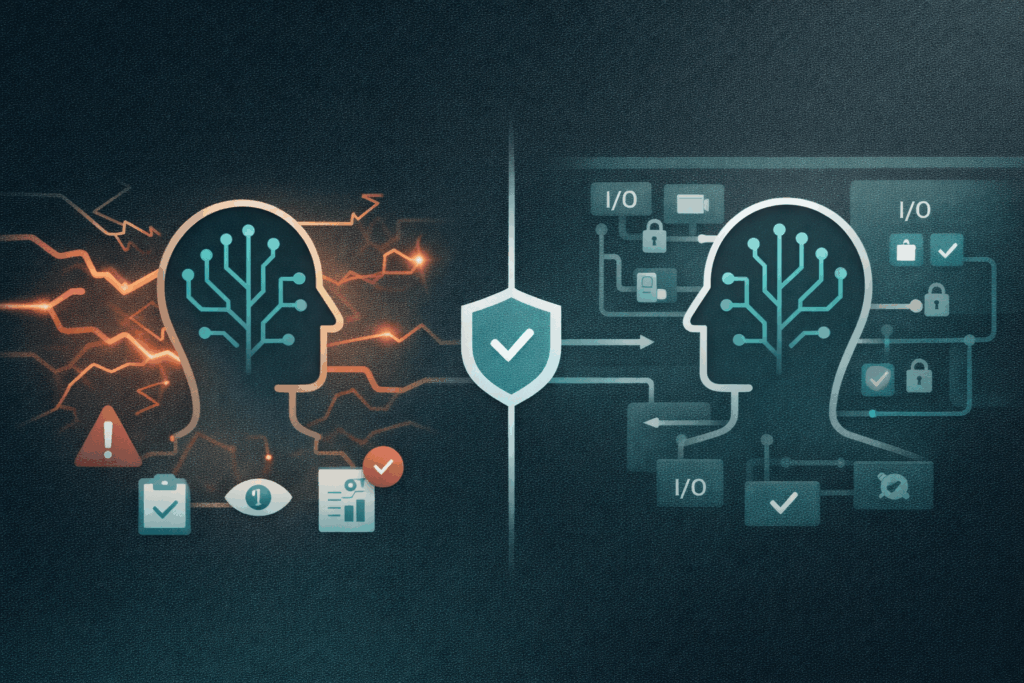

1.AIの暴走を防ぐガバナンス

Enterprise MCP Serverでは、AIエージェントがMCP Server経由でのみデータや業務機能にアクセスする構造を前提とします。

- API単位ではなく、エージェントの役割やスキルを意識したアクション単位での制御

- エージェント自身の権限に加え、最終利用者の権限を加味した多層的な制御

これにより、AIエージェントは「勝手に動く存在」ではなく、定義されたI/Oの中で動作する制御対象として扱えるようになります。

2.責務分離を前提としたデータアクセス管理

OTの世界では、「この装置が、この信号を見る理由は何か」という問いが常に存在します。

Enterprise MCP Serverでは、

- どのAIエージェントが

- どの装置やユーザーの文脈で

- どのデータを

- どの目的で利用するのか

- どのスキルを行使できるのか

といった点を明確に定義します。

これにより、過剰なデータアクセスの防止、セキュリティや監査要件への対応、将来的な構成変更への柔軟性が確保されます。

3.判断精度を高める知識とスキルの供給

エージェント型AIの判断精度は、LLMの性能以上に「与えられるコンテキスト」に依存します。

Enterprise MCP Serverは単なる中継点ではありません。

- 業務ルール

- 過去の判断事例

- 現場特有の制約条件

- 判断時の前提や禁止事項

といったナレッジやスキルを、AIに正しい形で提供します。

その結果、AIは「それらしく考える存在」ではなく、現場の前提を理解したうえで判断できる存在へと進化します。

エンジニア視点で見た本質的な価値

エンジニアにとって重要なのは、AIエージェントの数を増やすことでも、単に賢くすることでもありません。

重要なのは、「増えても、入れ替わっても、業務プロセスが壊れない構造」を担保することです。

Enterprise MCP Serverは、AIエージェントが増えても、構成が変わっても、新しいユースケースが追加されても、全体の秩序を保つ制御基盤として機能します。

まとめ:エージェント型AI時代に求められるのは「知能」ではなく「設計」

エージェント型AIの未来は、すでに現実のものとなりつつあります。

その未来がカオスになるのか、制御された進化になるのか、信頼を獲得できるかどうかは、どのような設計思想を採用するかで決まります。Enterprise MCP Serverは、エージェント型AIを「現場に出せる存在」へと進化させるための基盤です。

OTエンジニアが長年培ってきた制御、安全、責務分離の知恵こそが、これからのエージェント型AI時代に最も求められています。